Pytorch-Mobile: FLOPs的计算

一、定义

区分FLOPS和FLOPs:

• FLOPS 注意全部大写 是floating point of per second的缩写,意指每秒浮点运算次数。可以理解为计算速度,用来衡量硬件的性能。

• FLOPs 是floating point of operations的缩写,是浮点运算次数,理解为计算量,可以用来衡量算法/模型复杂度。(ps:FLOPs 是模型推理时间的一个参考量,但并不能百分百表示该模型推理时间的长短,因为乘法和加法计算不一样,乘法的时间一般是加法时间的四倍,但现在有很多优化卷积层的计算算法,可能把乘法计算时间缩为加法的两倍不等,所以FLOPs只是个估量的指标,不是决定推理时间长短的指标。即FLOPs越小并不代表着模型推理时间越短)

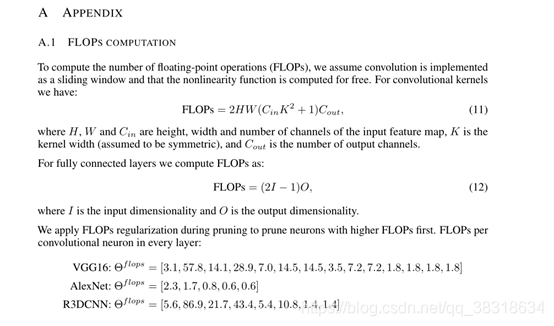

定义在这篇论文有:

二、CNNFLOPs计算包

import torch

import torchvision

from torch.utils.mobile_optimizer import optimize_for_mobile

from thop import profile

model = torchvision.models.GoogLeNet(init_weights=True)

example = torch.rand(1, 3, 224, 224)

flops, params = profile(model, inputs=(example,))

print(flops/1e9)

# model.eval()

# traced_script_module = torch.jit.trace(model, example)

# traced_script_module_optimized = optimize_for_mobile(traced_script_module)

# traced_script_module_optimized._save_for_lite_interpreter(r"D:\paper_code\01transformer\my_work\model\GoogleNet.pt")三、常见CNN的FLOPs及其在pytorch mobile下的latency总结:

FLOPs采用thop包计算

Latency是在Pixel 2 API 29下计算100次取平均

| 名称 | FLOPs(GFLOPs) | Latency(ms) |

| VGG16 | 15.483862016 | 1791.4 |

| resnet18 | 1.819066368 | 190.82 |

| resnet34 | 3.671263232 | 408.05 |

| resnet50 | 4.111514624 | 445.56 |

| resnet152 | 11.558837248 | 1362.19 |

| GoogleNet | 1.504879712 | 180.35 |