神经网络和卷积神经网络的理论分析

目录

计算机学者从生物视觉的研究中得到启示,一个视觉神经细胞只与其距离较近的邻层神经元相连。鉴于此,CNN的采用了局部感受野。为了简化模型,一个特征平面的神经元共享权值。CNN最早由YannLecun 实现并运用到手写数字识别问题中,并取得该领域最高的识别率,至今未被超越。CNN是NN的一种变形,CNN与NN最大的不同在于CNN的卷积和子采样过程,而子采样可以被认为是一种特殊的卷积过程。在本章的后半部分,将以切割小图训练共享权值的NN的方式阐释卷积神经网络中的卷积过程。

1.神经网络

神经网络(neural network,NN)是生物科学和信息科学交叉的产物。生物学家研究人脑神经的工作过程,发现神经元(神经细胞)和神经元之间通过突起(轴突和树突)的相连,神经细胞感受到刺激之后产生兴奋并通过细胞突起将兴奋传导给与之有连接的神经元。神经元的连接大多是相邻层间的连接,神经细胞总体上呈现分层结构,感受器中的神经接收外界刺激,神经中枢的神经元决定人脑的意识。

一个神经元通常和若干个神经元相连,连接有强有弱,不同的连接就像电子元件之间阻值不同的带阻导体。一个非输入神经元在兴奋传导过程中受到的刺激总和为与之相连的神经元传递来的兴奋之和。

2.卷积神经网络

卷积神经网络与普通神经网络的区别在于,卷积神经网络包含了一个由卷积层和子采样层构成的特征抽取器。在卷积神经网络的卷积层中,一个神经元只与部分邻层神经元连接。在CNN的一个卷积层中,通常包含若干个特征平面(featureMap),每个特征平面由一些矩形排列的的神经元组成,同一特征平面的神经元共享权值,这里共享的权值就是卷积核。卷积核一般以随机小数矩阵的形式初始化,在网络的训练过程中卷积核将学习得到合理的权值。共享权值(卷积核)带来的直接好处是减少网络各层之间的连接,同时又降低了过拟合的风险。子采样也叫做池化(pooling),通常有均值子采样(mean pooling)和最大值子采样(max pooling)两种形式。子采样可以看作一种特殊的卷积过程。卷积和子采样大大简化了模型复杂度,减少了模型的参数。

2.1卷积神经网络的常用结构

卷积神经网络通常采用若干个卷积和子采样层的叠加结构作为特征抽取器。卷积层与子采样层不断将特征图缩小,但是特征图的数量往往增多。特征抽取器后面接一个分类器,分类器通常由一个多层感知机构成。在特征抽取器的末尾,我们将所有的特征图展开并排列成为一个向量,称为特征向量,该特征向量作为后层分类器的输入。

2.2 卷积与子采样

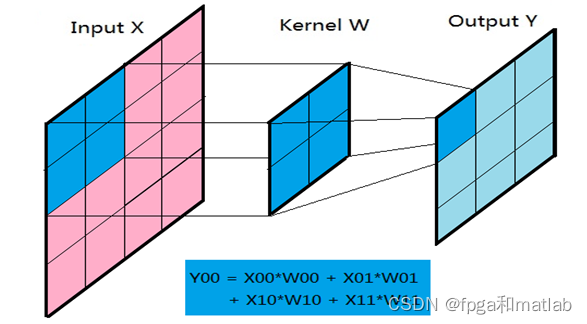

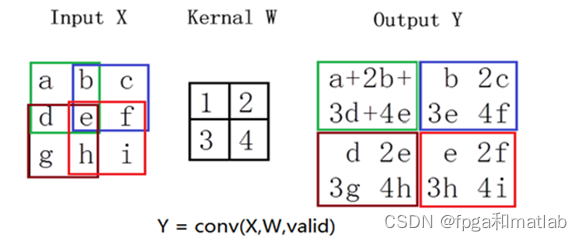

卷积过程有三个二维矩阵参与,它们分别是两个特征图和一个卷积核:原图inputX、输出图outputY卷积核kernelW。卷积过程可以理解为卷积核kernalW覆盖在原图inputX的一个局部的面上,kernalW对应位置的权重乘于inputX对应神经元的输出,对各项乘积求和并赋值到outputY矩阵的对应位置。卷积核在inputX图中从左向右,从上至下每次移动一个位置,完成整张inputX的卷积过程。卷积过程如图所示。

2.3 卷积与权值共享

在卷积神经网络的卷积层,卷积核本质是神经元之间相互连接的权重,而且该权重被属于同一特征图的神经元所共享。在实际的网络训练过程中,输入神经元组成的特征图被交叠切割成卷积核大小的小图。每个小图通过卷积核与后层特征图的一个神经元连接。一个特征图上的所有小图和后层特征图中某个神经元的连接使用的是相同的卷积核,也就是同特征图的神经元共享了连接权重。

在人工神经网络中,一个非输入神经元表征了某种特征,一个非输入神经元又可以由与之相关的前层连接表示,通过权重的还原,我们可以看到每个神经元代表的特征,神经元特征是逐层具象化的。在卷积神经网络中,卷积核是神经元之间的连接权重,如果只用来训练局部,可以代表局部某种特征,但是它被一个特征图共享,用来训练整个特征图,代表了比较通用(适用于全图)的某种的特征。中我们往往在卷积神经网络中设置多个卷积层,在一个卷积层中设置多个卷积核,以得到丰富的特征供尾部的分类器使用。

2.4卷积的作用

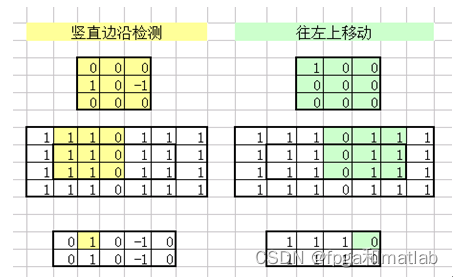

训练之后的卷积核有些能突显图像的边缘特征,有些能对原图产生了震颤效果。通过丰富的卷积核,卷积可以提炼原题的某些特征,同时模型将对目标在产生偏移、缩放或者轻微形变的时候变得鲁棒。

另外,我们要可以将第一层卷积核固定,设置为特定的算子,如边沿检测算子,平移算子,模糊算子。每个卷积核处理完一个特征图之后得到一个新的特征图,多个卷积可以得到多个特征图,这个过程相当于增加了训练集,相当于对模型进行了数据增量训练,使模型的鲁棒性更好。

3.神经网络和卷积神经网络的区别

从理论角度来看,神经网络和卷积神经网络都是基于梯度下降的优化算法进行训练的。在训练过程中,网络通过不断调整神经元的权重和偏置来最小化损失函数,从而学习到输入数据的特征和规律。

然而,由于神经网络和卷积神经网络的结构和连接方式的不同,它们在处理不同类型的数据和任务时具有不同的优势和局限性。例如,在处理图像数据时,卷积神经网络由于具有局部连接和权值共享的特点,能够更有效地提取图像中的局部特征,因此在图像分类、目标检测等任务上表现优异。而传统的神经网络在处理序列数据(如文本、语音等)时具有更强的建模能力,因此在自然语言处理、语音识别等领域应用广泛。

此外,神经网络和卷积神经网络的性能和效果还受到诸多因素的影响,如网络结构、神经元数量、激活函数选择、学习率设置等。在实际应用中,需要根据具体的数据和任务特点选择合适的网络结构和参数设置,以达到最佳的性能和效果。