DALL·E 3:Improving Image Generation with Better Captions

论文链接:https://cdn.openai.com/papers/dall-e-3.pdf

DALLE3 API:https://github.com/Agora-X/Dalle3

官网链接:添加链接描述

DALLE3讲解视频:B站视频

推荐DALLE2的讲解视频:B站:跟李沐学AI 之前精讲的DALLE2论文

北理&上海AI Lab&清华提出 Mini DALL·E 3:https://arxiv.org/pdf/2310.07653.pdf

code:https://github.com/Zeqiang-Lai/Mini-DALLE3

要点分析

文章主要在讲:通过更好的文本标注(Better Captions),提升图像生成质量

1. 摘要(Abstract)

- 解决问题:因为数据比较noise,很难按照prompt生成需要的图片

- 方法/贡献:提出image captioner(图片标注器),生成图像精准的标注,去训练模型

3. 文章主体

3.1. 数据生成方法

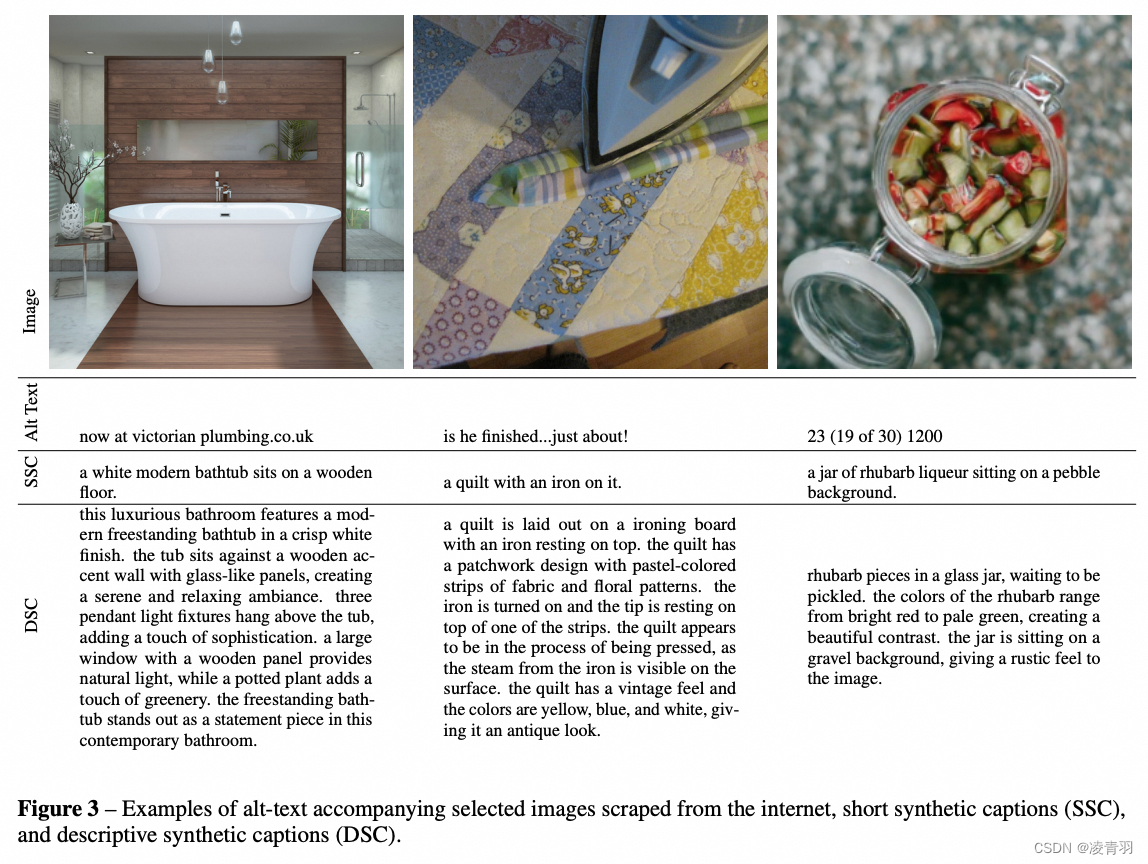

- 两种标注模式:

- 1.短标注:只描述主要物体,主体

- 详细标注:主体、环境、背景、文字、风格等

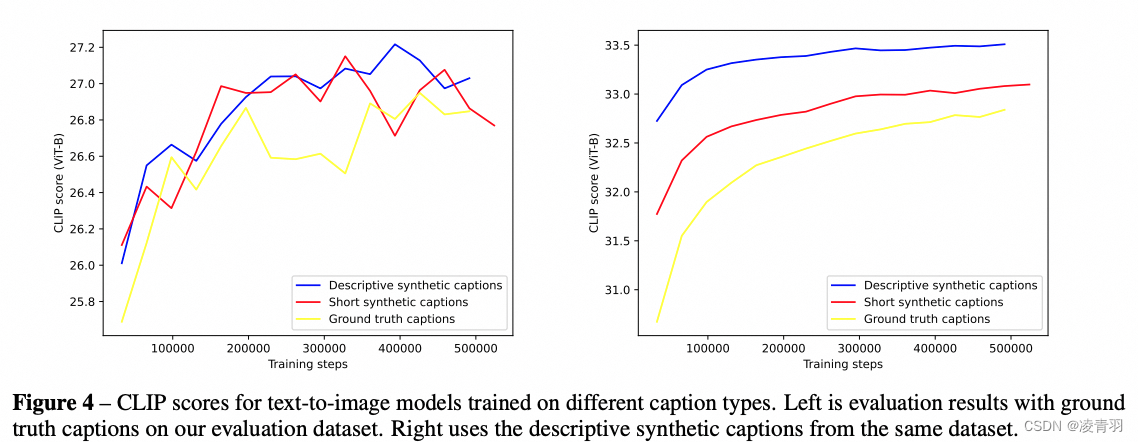

- Clip scores高于短标注

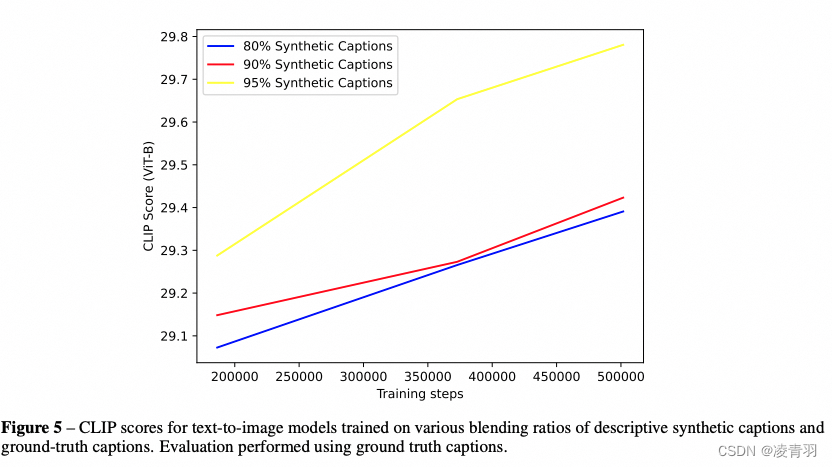

- 生成标注+原始文本标注的比例【意思train的时候加入生成标签,test的时候不加入呗?】

- 混合原因:生成文本是基于数据的模式,用户的文本(原始标注)有自己的风格,原始标注相当于正则

- 95%> 90% > 80%,但是不是100%最好

- 用户的prompt简短,不能充分发挥模型能力

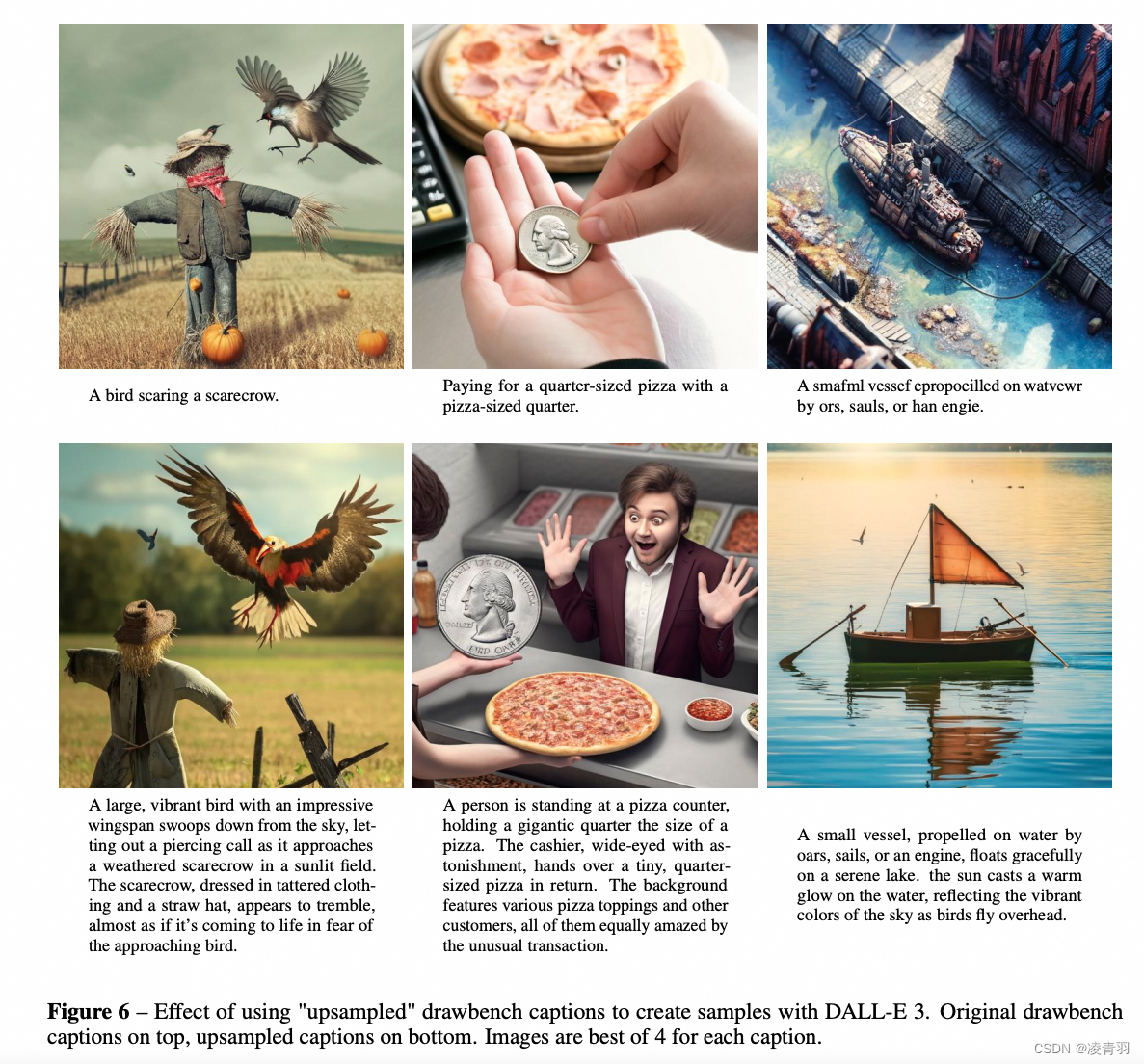

- 用GPT扩写用户的prompt

- 用GPT扩写用户的prompt

3.2. 评估方式

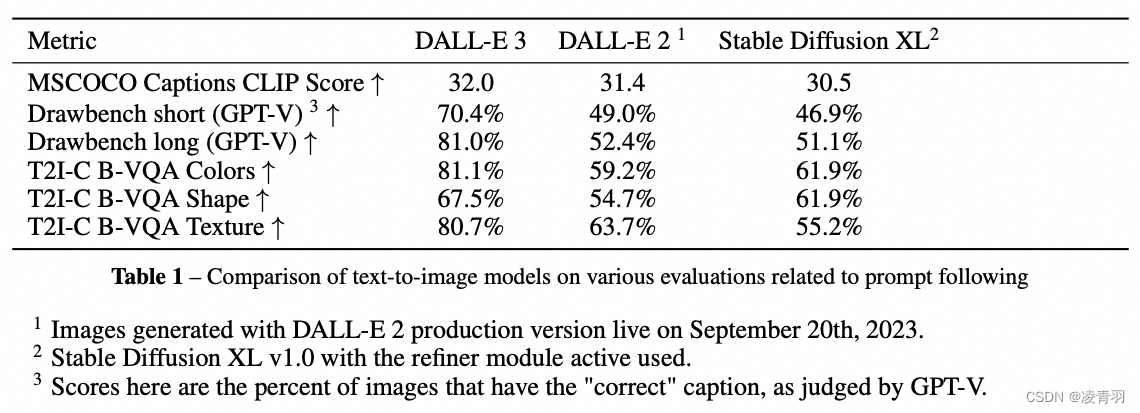

- 自动评估:

- Clip scores:用Ms COCO的caption生成图片,然后用Clip scores去评估图片文本之间的匹配程度

- Drawbench:Images提出的比较全的评测prompts,然后用GPT-V(多模态)来评估生成突破和Prompts的匹配度(生成模型评估生成模型hh)

- T2l-Compbench:与Drawbench类似,区别在于GPT-V换成VQA

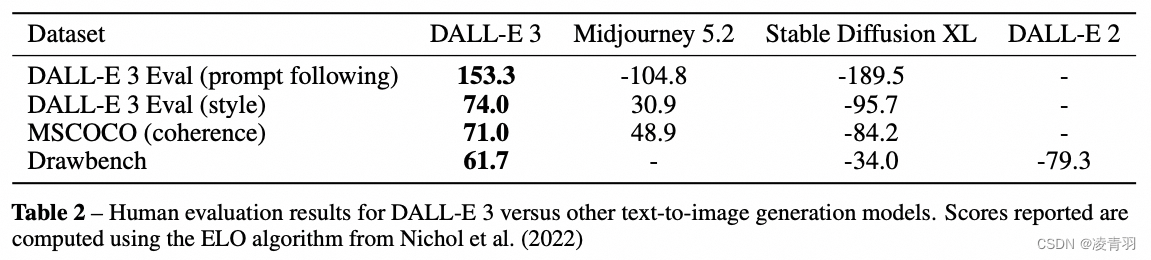

- 人工评估:

- Prompt fllowing:Prompts和图像匹配程度

- style:图片质量,评估者是看不到Prompts,直接看两张图片哪个更好

- coherence:观察不合理的结构,虚幻的场景人工评估打低分,作者换成用MS COCO的Caption生成的图像去做评估

4. 实验效果

- 评估结果:DALL-E 3 > Midjourney 5.2 > Stable Diffusion XL > DALL-E 2

5. 总结

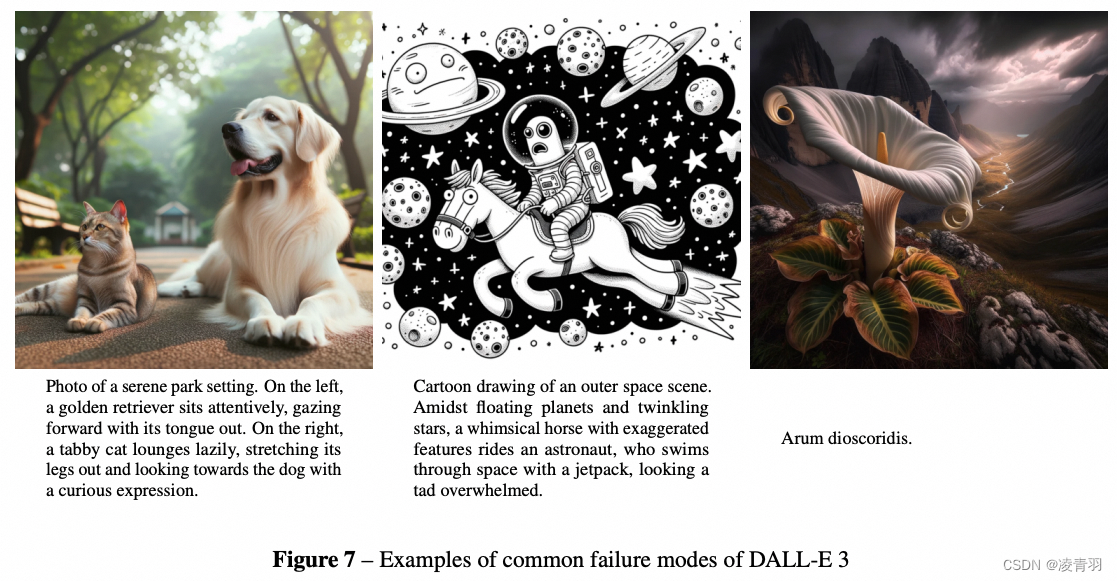

方法局限性:

- 位置关系不准确

- 文字的生成不行:因为T5 text encoder的局限性,它会把用户的prompts分隔开,整体把握小