因果学习介绍

目前数据驱动的方法大多是建立数据和标签之间的关联,但是这种关联可能是有偏见或者错误的,因果学习就是想加入知识,来消除这种偏见。

机器学习是在大量数据的基础上,应用一些数学理论,尽可能建立一个模型,去拟合这些数据的分布情况。这个模型就像是一个函数,当给模型输入了参数之后,就会生成符合上述数据分布的预测结果。

因果机器学习(CausalML)是将数据生成过程形式化为结构因果模型(SCM)的机器学习方法的总称。这使得人们可以对这一过程的变化的影响(即干预)和事后会发生什么(即反事实)进行推理。根据他们所解决的问题,我们将CausalML中的工作分为五组:(1)因果监督学习,(2) 因果生成模型,(3) 因果解释,(4) 因果公平,(5) 因果强化学习。对每一类方法进行了系统的比较,并指出了有待解决的问题。

那么为什么上述机器学习模型容易在数据分布变化时出现决策失误呢? 因为它可能学到了不具备泛化性能的关联性,相对I.I.D.(独立同分布)假设下的模型学习,这种训练环境和测试环境的数据分布不同的问题称为Non-I.I.D.或者OOD(Out-of-Distribution)。模型需要学到做出预测或判断的本质原因和规律,而非依赖于表面“看上去”的关联关系。人们已经发现标准的有监督学习方法,特别是深度学习方法对分布外样例的预测表现欠佳。若训练集中大部分“哈士奇”的图片都是暗背景而大部分“狼”的图片都是雪地背景,那对于处在雪地中的“哈士奇”的测试样例,模型会预测为“狼”。若对模型进行可视化可发现模型更关注于背景,因为在这样的数据集上,背景与前景物体具有很强的关联性,并且背景是一个比前景物体更有区分度的特征,但只有前景物体决定图片的标注。

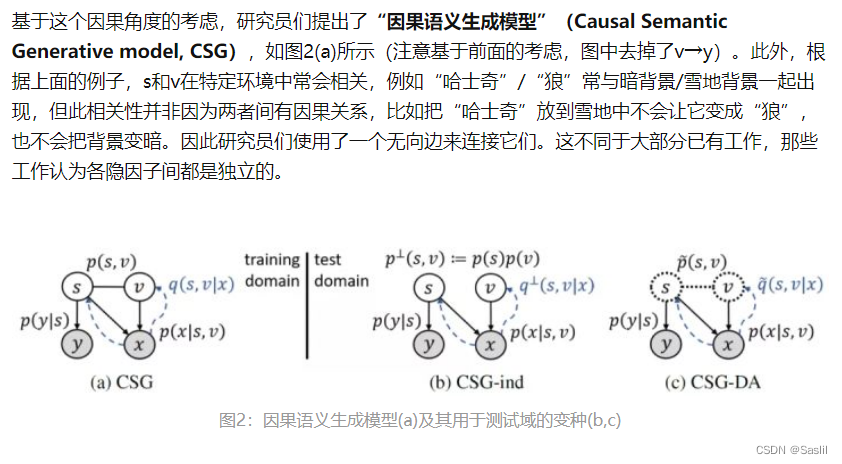

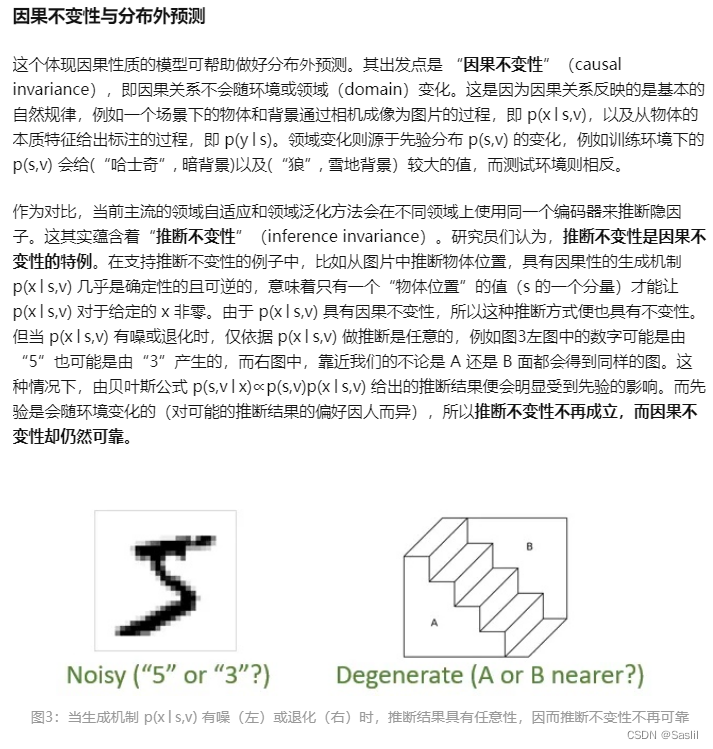

希望模型能够学到类似于前景物体这样的特征进行预测。此目标可在因果关系理论下进行正式的描述。该理论是通过系统在干预(intervention)下的表现来定义因果关系的,即若通过干预改变变量 A 的值会改变变量 B 的值而干预 B 不会改变 A,那 A 就是 B 的因(cause),B 就是 A 的果(effect),记为 A→B。若强行改变一张图 x 的背景而维持前景物体不变,那这张图的标注 y 不应改变,而改变前景物体却会改变 y。所以研究员们希望模型学到的是标注 y 的因,称为“语义因子”(semantic factor)s,如前景物体,而相区别的是“多变因子”(variation factor)v,如图片背景。只有将 s 识别出来才能做好分布外预测(out-of-distribution prediction)。